Spark是继Hadoop之后的新一代大数据分布式处理框架,由UC Berkeley的Matei Zaharia主导开发。

操作在Ubuntu 15.04进行,JDK版本1.8,Hadoop版本2.6,Scala版本2.11.7

1、Scala的安装

Spark基于Scala语言编写,在安装Spark前应先安装Scala语言。当前版本为2.11.7。

Ubuntu软件中心中已经包括Scala,可以直接从软件中心安装,或直接输入命令

sudo apt-get install scala

此处仍采用从官网下载压缩包后手动安装。

安装包下载完毕后解压到安装文件夹。

tar -zxvf scala-2.11.7.tgz -C /usr/scala

解压完毕后需配置环境变量。通过gedit或vi编辑器进行。

sudo gedit /etc/profile

在结尾输入

export SCALA_HOME=/usr/scala/scala-2.11.7

export PATH=$PATH:$SCALA_HOME/bin

执行文件# ./etc/profile,以立即启动配置

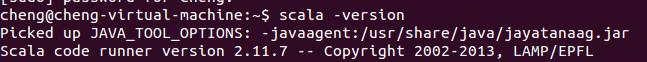

验证Scala

输入命令scala -version,应显示版本信息

Scala版本

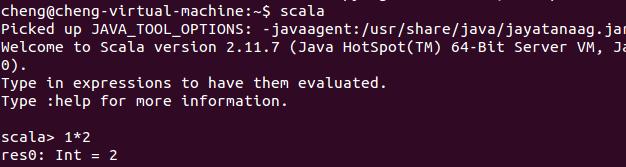

输入Scala启动Scala,可进行验证

验证,程序为1*2=?

2.安装Spark

Scala安装完毕后可以开始安装Spark。

Spark可以从官网或Github获取。得到压缩包后解压至安装目录。

tar -zxvf spark.1.5.0-bin-hadoop2.6.tgz -C /usr/spark

配置Spark环境变量

单机运行此步骤可省略。打开/etc/profile文件,结尾添加

export SPARK_HOME=/usr/spark/spark-1.5.0-bin-hadoop2.6

export PATH=$PATH:$SPARK_HOME/bin

(注:在集群配置时此步骤至关重要,需要指定Master节点的IP等信息)

为方便访问此处可为当前用户赋予Spark目录权限

sudo chown -hR cheng /usr/spark (绿色部分为安装的当前用户的用户名)。

配置完毕后可启动Spark。

将当前目录定位到Spark目录下的sbin目录中。

输入./start-all.sh启动Spark。

可在浏览器中输入http://localhost:8080浏览当前节点运行情况。

输入./stop-all.sh结束Spark。

CentOS 6.2(64位)下安装Spark0.8.0详细记录:http://www.linuxdiyf.com/linux/10651.html

Spark搭建环境涉及的Linux命令:http://www.linuxdiyf.com/linux/10244.html

Spark源码包的编译:http://www.linuxdiyf.com/linux/7026.html