1、前期准备:已经安装好了jdk、hadoop、eclipse.

2、下载 hadoop-eclipse-plugin-1.2.1.jar。然后把jar包放到eclipse/plugins文件目录下。重启eclipse,会看到,工作界面多了个图标

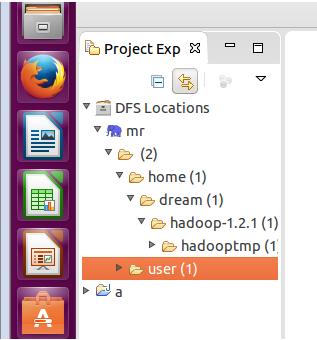

左侧“Project Explorer”下面发现“DFS Locations”,说明Eclipse已经识别刚才放入的Hadoop Eclipse插件了。

3、把工作目录切换到map/reduce

选择“Window”菜单下选择“Open Perspective–>Other”,弹出一个窗体,从中选择“Map/Reduce”选项即可进行切换。

4、配置DFS Locations

在Eclipse软件下面的“Map/Reduce Locations”择“New Hadoop Location ”跳出界面如下:

名字随便起,这里的端口号都是你之前在设置Hadoop的那。

把use M/R Master host 勾选。finish退出。

看到如下目录:

到此,配置完成。

5、可以在hdfs里面新建文件夹,然后就可以把需要处理的文件放到这个文件夹。

bin/hadoop dfs -mkdir test

ubuntu15.04搭建eclipse环境:http://www.linuxdiyf.com/linux/15007.html

Ubuntu15.04下JavaJDK的安装和eclipse的安装:http://www.linuxdiyf.com/linux/12531.html

在Ubuntu 15.04中使用Eclipse 4.4、Java 8以及WTP:http://www.linuxdiyf.com/linux/11736.html

ubuntu15.04下安装eclipse4.4:http://www.linuxdiyf.com/linux/12322.html

ubuntu15.04安裝hadoop2.6.0及eclipse开发环境配置:http://www.linuxdiyf.com/linux/12474.html

Ubuntu下使用Eclipse和PyDev搭建完美Python开发环境:http://www.linuxdiyf.com/linux/6257.html